저번에 이어서 Lyapunov's Direct method에 필요한 Quadratic functions에 대해서 공부하겠습니다.

1. Quadratic Functions

Quadratic : 이차의, ex) quadratic equation : 이차방정식

definition

$\text{A quadratic function }Q:R^{n}\rightarrow R \text{ is a function of the form :}$

quadratic function은 일종에 어떤 $x\in mathbb{R}^{n}$라는 state 벡터가 있을 때 각 성분의 combination의 조합이라고 할 수 있습니다. 참고로 quadratic function은 $1\times 1 $ matrix입니다.

위에서 나왔던 것처럼 P는 symmetric이라는 조건이 있기 때문에 $p_{ij}=p_{ji}$이므로 $p_{ij}x_{i}x_{j}=p_{ji}x_{j}x_{i}$입니다.

또한 모든 square matrices는 symmetric part와 skew symmetric part로 나눌 수 있습니다.

어떤 square matrix를 M이라고 할 때, 이 matrix를 symmertic matrix P와 skew-symmetric matrix S로 나눴다고 합시다.

$M = P + S$

$P = \frac{1}{2}(M+M^{T}) \Rightarrow P=P^{T}$

$S= \frac{1}{2}(M-M^{T}) \Rightarrow S=-S^{T}$

M의 quadratic function을 구해보면,

$x^{T}Mx=x^{T}(P+S)x=x^{T}Px + x^{T}Sx = x^{T}Px$ $(\because x^{T}Sx=0)$

$\text{Proof for }x^{T}Sx=0$

$x^{T}Sx=(x^{T}Sx)^{T} (\because x^{T}Sx\text{ is 1x1 matrix})=x^{T}S^{T}x=-x^{T}Sx$

이를 정리하면 $2x^{T}Sx=0$

$\therefore x^{T}Sx=0$

2. Symmetric matrix

symmetric matrix는 $A=A^{T}$가 성립하는, 즉 matrix의 transpose와 matrix가 동일한 matrix를 말합니다.

symmetric matrix의 성질에 대해서 이야기하겠습니다. 주의해야할 것은, 여기서 말하는 symmetric matrix는 모두 $R^{n\times n}$이라는 점입니다. 즉, 모든 elements가 실수일 때를 말합니다.

1) symmetric matrix의 모든 eigenvalues는 real이다.

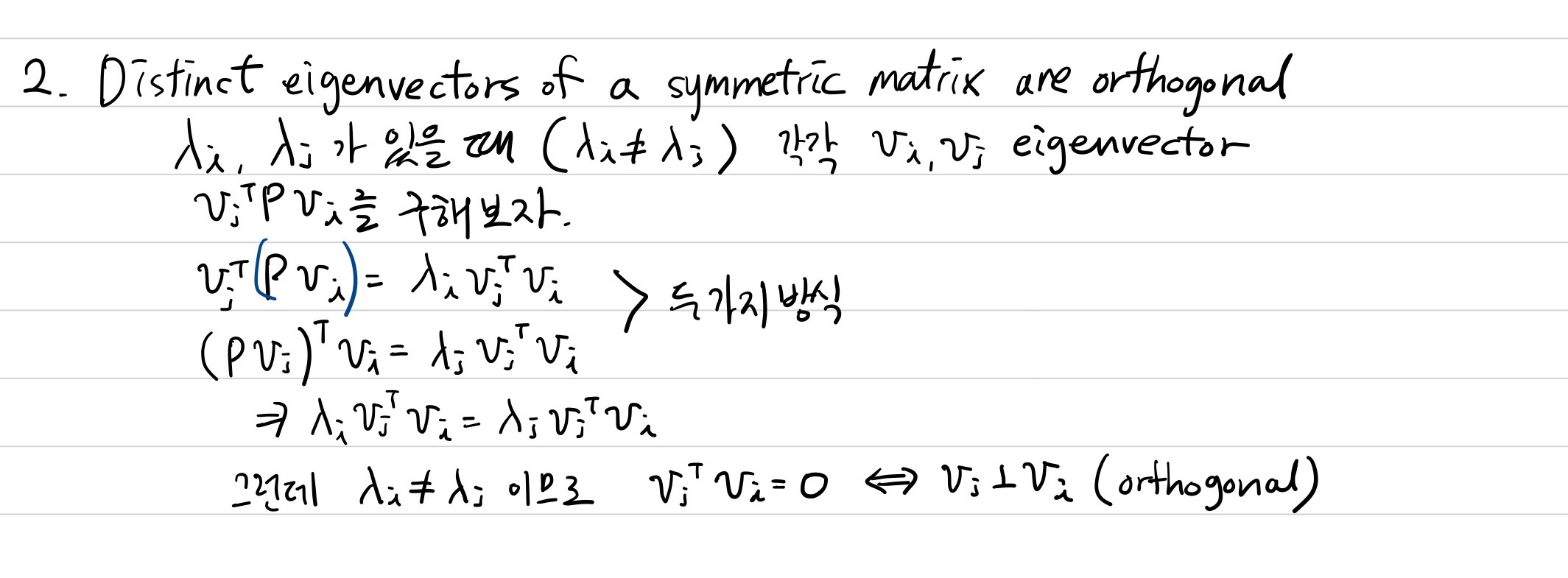

2) symmetric matrix의 서로 다른 eigenvectors는 orthogonal이다.

3) symmetric matrix는 항상 diagonalize할 수 있다.

제가 위에서 symmetrix matrix는 real elements라고 했는데, 만약 matrix가

$\begin{bmatrix} 1 & i \\ i & 1 \end{bmatrix}$라는 대칭함수이면, eigenvalue를 구해보면

$(1-\lambda)^{2}+1=0$이므로 eigenvalues가 complex number가 됩니다.

(각각에 대한 증명은 나중에 시간이 나면 적는 걸로)

3. Hermitian matrix

Definition

$\text{A matrix H}\in \mathbb{C}^{n \times n}\text{is called Hermitian if }H=H^{*}$

matrix의 conjugate transpose가 원래 matrix와 같을 때 hermitian matrix라고 합니다.

위의 정의와 같이 $H\in \mathbb{C}^{n\times n}$인데요, 만약 이 matrix가 실수라면, hermitian matrix는 곧 symmetric matrix입니다. 즉, hermitian matrix의 특수한 경우가 symmetric matrix인 것입니다.

이 Hermitian matrix가 positive definite인지 알 수 있는 방법이 몇 개 있습니다.

다음의 Theorem을 살펴보겠습니다.

Theorem

$\text{A hermitian matrix P is positive definite (positive semidefinite) if and only if any one of the following conditions holds;}$

$\text{1. All the eigenvalues of P are positive(nonnegative)}$

$\text{2. All the leading principal minors of P are positive (all the principal minors of P are nonnegative)}$

$\text{3. There exists a nonsingular N (a singular matrix N) such that P=N*N}$

이 세 개의 조건은 모두 동치입니다. 괄호 안에 있는 글은 positive semidefinite에 해당하는 조건입니다.

두 번째 조건의 'principal minors'에 대해서 잘 기억이 안 나서 찾아봤습니다.

위키피디아(en.wikipedia.org/wiki/Minor_(linear_algebra))에서

a minor of a matrix A is the determinant of some smaller square matrix, cut down from A by removing one or more of its rows and columns.

라고 합니다. 즉 특정 matrix가 있을 때 column과 row를 제거하여 얻은 square matrix에 대한 determinant입니다.

예를 들어

$P=\begin{bmatrix} p_{11} & p_{12} & p_{13} \\ p_{21} & p_{22} & p_{23} \\ p_{31} & p_{32} & p_{33} \end{bmatrix}$

다음과 같은 P matrix가 있을 때 minor of P of order k는 P에서 행과 열을 제거해서 얻은 $k\times k\text{matrix}$의 determinant를 말합니다.

$M_{1,1}=det\begin{bmatrix}p_{22} & p_{23} \\ p_{32} & p_{33}\end{bmatrix}$

$M_{1,1}$은 첫 번째 열과 행을 지운 matrix의 determinant입니다.

principal minors는 minors of order k 중에서도 동일한 숫자의 열과 행을 지운 minors를 말합니다.

예를 들면

$\begin{vmatrix} p_{11} & p_{12} \\ p_{21} & p_{22} \end{vmatrix}$

는 P matrix의 세 번째 열과 세 번째 행을 지운 다음에 구한 determinant이므로 principal minors입니다.

마찬가지로 $\begin{vmatrix} p_{22} & p_{23} \\ p_{32} & p_{33} \end{vmatrix}$는 첫 번째 열과 첫 번째 행을 지웠고,

$\begin{vmatrix} p_{11} & p_{13} \\ p_{31} & p_{33} \end{vmatrix}$는 두 번째 열과 두 번째 행을 지우고 구한 determinant입니다.

이렇게 같은 열과 행을 지워서 얻은 minors를 principal minors라고 합니다.

위의 2 by 2 matrix지만 다른 order의 minor에게도 적용하면 이 P matrix의 총 principal minors는

$p_{11}, p_{22}, p_{33}, \begin{vmatrix} p_{11} & p_{12} \\ p_{21} & p_{22} \end{vmatrix}, \begin{vmatrix} p_{22} & p_{23} \\ p_{32} & p_{33} \end{vmatrix}, \begin{vmatrix} p_{11} & p_{13} \\ p_{31} & p_{33} \end{vmatrix}, det[P]$

입니다.

이 중에서 leading principal minors는 행과 열을 제거할 때 마지막 행, 열을 제거한 쪽을 선택하는데요,

$p_{11}, \begin{vmatrix} p_{11} & p_{12} \\ p_{21} & p_{22} \end{vmatrix}, det[P]$

입니다.

이 principal minors가 양수이면 positive definite하다는 것도 다시 떠올리면 좋을 듯합니다.

다음에는 이제 본격적으로 Lyapunov's Direct method에 대한 내용으로 넘어가겠습니다.

'연구 Research > 제어 Control' 카테고리의 다른 글

| [고등자동제어] Lyapunov's Direct Method (4) - Lyapunov equation (0) | 2021.01.24 |

|---|---|

| [고등자동제어] Lyapunov's Direct Method (3) - Lyapunov function (0) | 2021.01.23 |

| [고등자동제어] Lyapunov Direct Method (1) - Positive definite (0) | 2021.01.22 |

| [고등자동제어] Stability in the sense of Lyapunov (3) (0) | 2021.01.15 |

| [고등자동제어] Stability in the sense of Lyapunov (2) (1) | 2021.01.07 |