1. Length of vectors

[x1⋮xn]∈Rn

vector의 길이(‖x‖)에 대한 식은 다음과 같습니다

‖x‖=√x21+x22+⋯+x2n=xTx

2. Orthogonality

x,y∈Rn

x,y라는 n차원 벡터가 있을 때 두 벡터가 수직이라고 해보자.

피타고라스 공식에 의해

‖x−y‖2=‖x‖2+‖y‖2⋯(1)이 성립합니다.

또한 ‖x−y‖2은 (xT−yT)(x−y)와 같습니다. 따라서

(xT−yT)(x−y)=xTx+yTy−xTy−yTx=‖x‖2+‖y‖2−2xTy⋯(2)

위에서 구한 두 식은 같으므로 ‖x‖2+‖y‖2=(1)=(2)=‖x‖2+‖y‖2−2xTy

∴xTy=0

만약 두 벡터가 이루는 각이 π2보다 작다면

‖x−y‖2=‖x‖2+‖y‖2−2xTy<‖x‖2+‖y‖2

만약 두 벡터가 이루는 각이 π2보다 크다면

‖x−y‖2=‖x‖2+‖y‖2−2xTy>‖x‖2+‖y‖2

이 과정을 정리해보도록 하겠습니다.

Definition)

(1). (x,y)=xTy=x1y1+x2y2+⋯+xnyn

(2). x and y are orthogonal if and only if xTy=0

위의 설명에서 두 벡터 사이의 각도를 θ라고 할 때,

θ<π2이면 xTy>0⇒‖x‖2+‖y‖2−2xTy<‖x‖2+‖y‖2

θ>π2이면 xTy<0⇒‖x‖2+‖y‖2−2xTy>‖x‖2+‖y‖2

이는 고등학생 때 배웠던 내적공식 x⋅y=|x||y|cosθ와도 일치하는 내용입니다.

Remark)

(1). 0 is orthogonal to any vector in Rn

(2). If x is orthogonal to x, then x=0⇔‖x‖2=xTx=0

Theorem)

The non-zero vectors v1,v2,…,vn are mutually orthogonal (vi)⊥(vj) for i≠j

Then v1,v2,…,vn are linearly independent.

Proof)

We need to show that if c1v1+c2v2+⋯+cnvn=0 then c1=c2=…=cn=0

consider vT1(c1v1+c2v2+⋯+cnvn)=0

c1vT1v1+c2vT1v2+⋯+cnvT1vn=0

모든 벡터가 서로 orthogonal이므로 vTivj=0

c1||v1||2=0⇒c1=0

마찬가지로 vTi(c1v1+…+cnvn)=0이면 ci=0

즉, 모든 c항이 0이므로 linearly independent임이 증명되었습니다.

3. Orthogonal basis

Definition)

V = a vector space

(1). a basis v1,v2,…,vn of V is called an orthogonal basis if vi⊥vj∀i≠j

(2). a basis v1,v2,…,vn of V is called an orthonormal basis if vi⊥vj∀i≠j

‖vi‖=1∀i

길이에 상관없이 각 벡터가 수직이면 linearly independent하므로 basis입니다. 여기서 길이 1이면 orthonormal basis입니다.

v1,v2,…,vn form an orthogonal basis of V

if v=c1v1+c2v2+⋯+cnvn then ci=vTiv

Proof) vT1v=vT1(c1v1+⋯+cnvn)=c1

NOTE : v1,v2,⋯,vn 가 an orthogonal basis of V를 이룰 때

v=c1v1+⋯+cnvn이면 ci=v⊤iv.

4. Orthogonal spaces

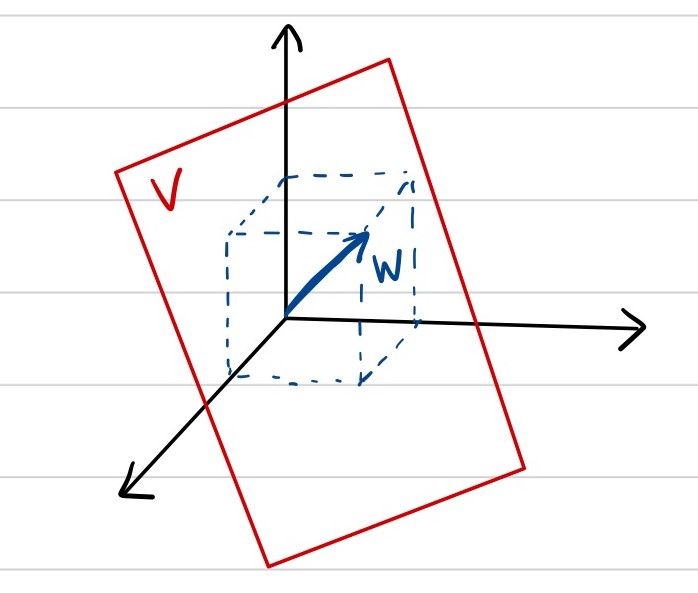

ex)

V:x+y+z=0 in R3

W={a[111],a∈R}

그림 상으로 보았을 때 두 vector space는 orthogonal합니다.

Definition)

V, W : two subspaces

V and W are orthogonal if V⊥W for any v∈V and w∈W

ex) suppose that {v1,…,vn span Vw1,…,wn span W

Then, V⊥W⇔vi⊥wj for any i,j

예를 들어 In R4

V is spanned by [1000] and [1100]

W is spanned by [0011]

보시면 [1000]⊥[0011]이고

[1000]⊥[0011]이므로

각 vector space에 속한 벡터들이 서로 orthogonal하므로 V⊥W입니다.

만약 L이라는 Vector space가 [00−11]으로 span되는 vector space라면

이 벡터는 위의 V,W를 span하는 벡터들과 모두 orthogonal하므로

L⊥V and L⊥W 임을 알 수 있습니다.

여기서 질문 : What space can be orthogonal to L,V,W?

정답은 0 영벡터입니다.

지금 보시면 L은 rank 1이고(basis element가 1개), V는 rank 2, W는 rank 1입니다.

R4에서 orthogonal한 vector space의 rank 총합이 4이므로, 이미 다른 linearly independent vector를 찾을 수 없습니다. 따라서 영벡터 외에는 L,V,W와 수직인 Vector space를 찾을 수 없습니다.

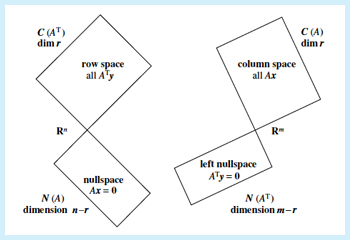

Fundamental theorem of orthogonality

그 전 글에서 배웠던 4개의 fundamental space를 다시 언급하려고 합니다.

Column space, Row space, Null space, Left null space를 orthogonal 관계로 설명할 수 있습니다.

Theorem) A : m×n matrix

N(A)⊥C(AT) and N(AT)⊥C(A)

proof)

① N(A)⊥C(AT) 첫 번째 증명 방법

x∈N(A)

[row 1row 2⋮row n][x]=[0]

즉, row i[x]=0⇔row i⊥x∀i

따라서 row space의 basis와 null space를 span하는 basis vector가 orthogonal이므로 두 space 역시 orthogonal입니다.

row i⊥x⇒N(A)⊥C(AT)

② 두 번째 증명 방법

For x∈N(A) and y∈C(AT)(y=ATu for some u)

증명을 위해서는 yTx=0⇔x⊥y임을 보여야합니다.

yTx=(ATu)Tx=(uTA)x=uT(Ax)=0(∵Ax=0)

N(AT)⊥C(A)도 비슷한 방법들로 증명할 수 있습니다.

정리하면

A:Rn→Rm→A∈Rm×n

dimC(A)=dimC(AT)=rank n (matrix와 그 matrix의 transpose는 차원이 동일합니다.)

dimN(A)+dimC(AT)=n

dimN(AT)+dimC(A)=m

matrix는 n차원에서 m차원으로 mapping하는 linear transformation으로 볼 수 있습니다.

C(A)는 A의 column으로 mapping한 것이므로 m차원 안에 속해있으며 column이 basis이냐, 아니냐에 따라 m차원을 모두 span할 수 있는지 아닌지가 결정됩니다. 같은 m차원 안에서 left nullspace는 C(A)와 수직인 관계를 가집니다.

유시하게 Row space(C(AT))는 n차원 안에 속하면서 row로 만들 수 있는 vector space가 됩니다. 같은 n차원에 속하면서 row space와 orthogonal한 nullspace도 있습니다.

이 관계를 잘 나타낸 것이 바로 아래 그림입니다.

5. Orthocomplement

Definition)

V : a subspace

orthocomplement of V which is denoted by V⊥

is given by V⊥={w:w⊥v for any v∈V}

- orthocomplement의 성질

(1). V⊥ is a subspace

(2). dimV⊥+dimV= dim of total space

(3). If V⊆Rn a subspace

Rn=V⊕V⊥

meaning for any x∈Rn, there are unique x1∈V1,x2∈V⊥ such that x=x1+x2

(4). (V⊥)⊥=V

이제 vector space와 그 vector space의 orthocomplement과의 관계를 알아보겠습니다.

V⊆Rn a subspace

orthocomplement V⊥={w:w⊥v∀v∈V}

(1). V⊥ is a vector space

v+w∈V⊥ if v,w∈V⊥

cv∈V⊥ if v∈V⊥,c∈R

proof) for any x∈V,xT(v+w)=xTv+xTw=0

xT(cv)=cxTv=0

(2). dimV+dimV⊥=n

proof) Let v1,v2,…,vm be a basis of V(m≤n)

Define A=[vT1vT2⋮vTm]m×n

만약 x∈VT인 벡터 x를 골랐을 때 x⊥vi∀i⇔Ax=0⇔x∈N(A)

기존에 dimN(A)=n−rank(A)=n−m임을 알고 있기 때문에

dimN(A)+m=n⇒dimVT+dimV=n(∵dimN(A)⇔dimV⊥,rank(A)⇔dimV)

(3). Rn=V⊕V⊥

meaning for any x∈Rn, there exist x1∈V,x2∈V⊥ uniquely such that x=x1+x2

(3)번은 Rn에 속한 어떤 벡터 x든 V와 V⊥에 있는 벡터들의 unique한 조합으로 표현할 수 있다는 뜻입니다.

예를 들어, 3차원 공간에서 xy평면인 vector space V와 xy평면에 orthogonal한 z축 방향 벡터로 이루어진 vector space V⊥이 있다고 생각해보겠습니다.

3차원 공간의 어떤 벡터든 xy평면의 벡터와 z축 방향의 벡터의 조합으로 표현할 수 있습니다.

- uniqueness 증명

x=x1+x2=y1+y2, where x1,y1∈V,x2,y2∈V⊥

x1−y1∈V=y2−x2∈V⊥

왼쪽 벡터는 vector space V에 속하고, 오른쪽 벡터는 V⊥에 속하므로 둘이 같다는 것이 모순이 되지 않으려면 x1−y1=0=y2−x2이어야 합니다. orthogonal한 관계의 vector space가 유일하게 공통으로 가지는 것이 영벡터이기 때문입니다.

∴x1=y1,x2=y2

마지막으로 앞서 보았던 four fundamental spaces가 orthogonal한 관계이라는 점을 이용해 다음과 같은 정리를 도출해낼 수 있습니다.

Theorem)

N(A)⊥=C(AT)

N(AT)⊥=C(A)

Ax=b is solvable ⇔b∈C(A)⇔b⊥N(AT)

다음에는 이 orthogonality 개념을 알고, 더 나아간 개념들을 공부할 생각입니다.

'수학 Mathematics > 선형대수학 Linear Algebra' 카테고리의 다른 글

| [응용선형대수] Cosines and Projection onto lines (0) | 2023.07.31 |

|---|---|

| [선형대수학] 행렬 분류 Matrix Phylogeny (0) | 2022.03.20 |

| [응용선형대수] Linear Transformations (0) | 2021.03.05 |

| [응용선형대수] The four fundamental subspaces (0) | 2021.03.04 |

| [응용선형대수] Linear independence, basis and dimensions (0) | 2021.03.02 |