[응용선형대수] Orthonormal bases and Gram-schmidt

·

수학 Mathematics/선형대수학 Linear Algebra

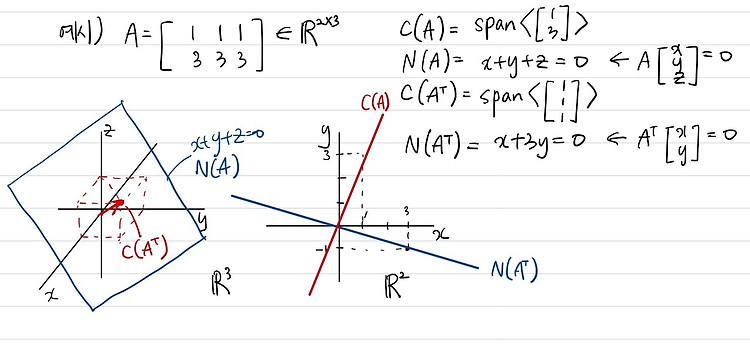

앞선 장에서는 projection과 cosine의 수학적 의미 등에 대해서 다루었다. 이번 장에서는 이러한 projection을 이용해서 space의 bases를 orthonormal bases로 바꾸는 방법에 대해 다룬다. 이렇게 하는 이유는 orthonormal bases일 때 가지고 있는 유용한 성질들 때문이다. Orthonormal bases $$ \text{Def)} Q \text{ is called an orthogonal ..